Алгоритмичните отклонения могат да повлияят на различни аспекти от живота ни, от получаване на препоръки за онлайн съдържание до намиране на работа и вземане на финансови решения.

Пристрастията са в човешката природа. Различните хора имат различен пол, раса, възпитание, образователен произход, култура, вярвания, опит и т.н.

По този начин техните мнения, мисли, харесвания и нехаресвания и предпочитания се различават едно от друго. Те могат да развият определени пристрастия към или срещу определени категории.

Машините не са по-различни. Те също могат да виждат хора, неща и събития по различен начин поради пристрастия, въведени в техните алгоритми. Поради тези пристрастия системите за изкуствен интелект и машинно обучение могат да доведат до нечестни резултати, затруднявайки хората по много начини.

В тази статия ще обсъдя какво представляват алгоритмичните отклонения, техните видове и как да ги открием и намалим, за да подобрим справедливостта на резултатите.

Нека да започнем!

Съдържание

Какво представляват алгоритмичните отклонения?

Алгоритмичното отклонение е тенденцията на алгоритмите за машинно обучение и изкуствен интелект да отразяват подобни на човека отклонения и да генерират несправедливи резултати. Пристрастията могат да се основават на пол, възраст, раса, религия, етническа принадлежност, култура и т.н.

В контекста на изкуствения интелект и машинното обучение, алгоритмичните отклонения са систематични, повтарящи се грешки, въведени в система, които водят до несправедливи резултати.

Пристрастия в алгоритмите могат да възникнат поради много причини, като решения, свързани с това как данните се събират, избират, кодират или използват при обучението на алгоритъма, предвидената употреба, дизайна на алгоритъма и т.н.

Пример: Можете да наблюдавате алгоритмично отклонение в резултат от търсачката, което води до нарушения на поверителността, социални отклонения и т.н.

Има много случаи на алгоритмични пристрастия в области като резултати от избори, разпространение на език на омразата онлайн, здравеопазване, наказателно правосъдие, набиране на персонал и т.н. Това усложнява съществуващите пристрастия по отношение на пола, расата, икономиката и обществото.

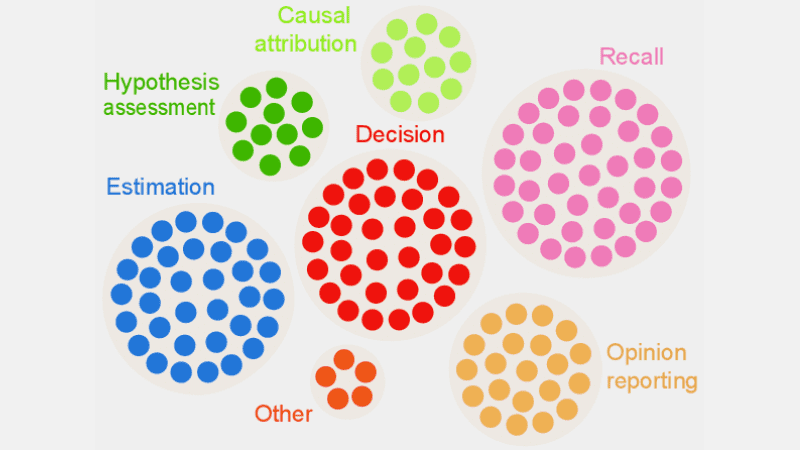

Видове алгоритмични отклонения

#1. Изкривяване на данните

Изкривяване на данните се случва, когато данните, необходими за обучение на AI модел, не представят правилно сценарии или популации от реалния свят. Това може да доведе до небалансирани или изкривени набори от данни.

източник: TELUS International

източник: TELUS International

Пример: Да предположим, че софтуерно решение за разпознаване на лица е обучено предимно върху бялото население. Така че може да се представи зле, когато има за задача да разпознава хора с по-тъмен цвят на кожата, което ги засяга.

#2. Отклонение при измерване

Това отклонение може да възникне поради грешка в процеса на измерване или събиране на данни.

Пример: Ако обучите диагностичен алгоритъм за здравеопазване да открива заболяване въз основа на някои показатели като предишни посещения при лекар, това може да замъгли преценката и да предизвика пристрастия, като същевременно пренебрегва действителните симптоми.

#3. Пристрастие към модела

При проектирането на алгоритъма или AI модела възникват отклонения от модела.

Пример: Да предположим, че AI система има алгоритъм, който е проектиран да максимизира печалбите, без значение как; може да се стигне до приоритизиране на финансовите печалби за сметка на бизнес етиката, безопасността, справедливостта и т.н.

#4. Пристрастност на оценката

Пристрастност при оценката може да възникне, когато факторите или критериите за оценка на ефективността на AI система са пристрастни.

източник: Изчистване на прегледа

източник: Изчистване на прегледа

Пример: Ако AI система за оценка на ефективността използва стандартни тестове, предпочитащи конкретна категория служители в компания, това може да насърчи неравенството.

#5. Отчитане на пристрастност

Пристрастие при отчитане може да възникне, когато в набора от данни за обучение липсва точно отражение на реалността в честотата на събитията.

Пример: Ако инструмент за сигурност на AI не работи добре в конкретна категория, той може да маркира цялата категория като подозрителна.

Това означава, че наборът от данни, на който е обучена системата, маркира всеки исторически инцидент, свързан с тази категория, като несигурен поради по-високата честота на инциденти.

#6. Пристрастие при избора

Пристрастие при избора възниква, когато данните за обучението са избрани без подходяща рандомизация или не представят добре общата популация.

Пример: Ако инструмент за лицево разпознаване е обучен на ограничени данни, той може да започне да показва известна дискриминация срещу данни, с които се сблъсква по-малко, като например идентифициране на цветнокожи жени в политиката, отколкото на мъже и лица с по-светла кожа в политиката.

#7. Неявно пристрастие

Неявни пристрастия възникват, когато AI алгоритъмът прави предположения въз основа на определени лични преживявания, които може да не се отнасят изрично за по-широки категории или хора.

Пример: Ако специалист по данни, който проектира AI алгоритъм лично вярва, че жените предпочитат предимно розово, а не синьо или черно, системата може да препоръча съответно продукти, което не се отнася за всяка жена. Много обичат синьо или черно.

#8. Пристрастност на груповото приписване

Това отклонение може да се случи, когато дизайнерите на алгоритъма прилагат неща, които са предназначени за определени индивиди, към пълна група, независимо дали тези индивиди са част от групата или не. Пристрастията към груповото приписване са често срещани в инструментите за набиране и приемане.

Пример: Инструмент за прием може да облагодетелства кандидати от конкретно училище, дискриминирайки други ученици, които не принадлежат към това училище.

#9. Исторически пристрастия

Събирането на исторически набори от данни е важно при събирането на набори от данни за обучение на ML алгоритъм. Но ако не обърнете внимание, във вашите алгоритми може да възникне отклонение поради отклоненията, присъстващи във вашите исторически данни.

Пример: Ако обучите AI модел с 10-годишни исторически данни за подбор на кандидати за технически позиции, той може да облагодетелства кандидатите мъже, ако в данните за обучение има повече мъже, отколкото жени.

#10. Пристрастие към етикета

Докато обучавате ML алгоритми, може да се наложи да етикетирате много данни, за да ги направите полезни. Въпреки това, процесът на етикетиране на данни може да варира много, генерирайки несъответствия и внасяйки пристрастия в AI системата.

Пример: Да предположим, че тренирате AI алгоритъм, като етикетирате котки в изображения с помощта на кутии. Ако не обърнете внимание, алгоритъмът може да не успее да идентифицира котка на снимка, ако лицето й не се вижда, но може да идентифицира тези с котешки лица върху тях.

Това означава, че алгоритъмът е предубеден при идентифицирането на снимки с обърнати отпред котки. Не може да идентифицира котката, ако изображението е взето от различен ъгъл, когато тялото се показва, но не и лицето.

#11. Пристрастност при изключване

източник: ResearchGate

източник: ResearchGate

Пристрастност при изключване възниква, когато конкретен човек, група хора или категория са изключени неволно или умишлено по време на събирането на данни, ако се смятат за неуместни. Най-често това се случва по време на етапа на подготовка на данните от жизнения цикъл на ML по време на почистване на данните и подготовката им за използване.

Пример: Да предположим, че базирана на AI система за прогнозиране трябва да определи популярността на конкретен продукт през зимния сезон въз основа на неговия процент на покупка. Така че, ако специалист по данни забележи някои покупки през октомври и премахне тези записи, смятайки ги за грешни и приемайки стандартната продължителност от ноември до януари. Но има места, където зимата надхвърля тези месеци. Така че алгоритъмът ще бъде предубеден към страните, получаващи зима от ноември до януари.

Как се въвеждат отклонения в алгоритмите?

Данни за обучение

Основният източник на алгоритмични пристрастия са пристрастните данни, използвани за обучение на алгоритмите за AI и ML. Ако самите данни за обучение съдържат елементи на неравенство и предразсъдъци в себе си, алгоритъмът ще научи тези елементи и ще увековечи пристрастията.

Дизайн

Когато проектира алгоритъма, разработчикът може съзнателно или несъзнателно да въведе отраженията на лични мисли или предпочитания в AI системата. Така че AI системата ще бъде предубедена към определени категории.

Вземане на решение

Много пъти учените по данни и лидерите вземат решения въз основа на техния личен опит, обкръжение, вярвания и т.н. Тези решения се отразяват и в алгоритмите, което води до отклонения.

Липса на разнообразие

Поради липса на разнообразие в екипа за разработка, членовете на екипа в крайна сметка създават алгоритми, които не представляват цялата популация. Те нямат опит или контакт с други култури, произход, вярвания, начини и т.н., поради което техните алгоритми могат да бъдат предубедени по определен начин.

Предварителна обработка на данни

Методът, използван за почистване и обработка на данни, може да въведе алгоритмично отклонение. Освен това, ако не проектирате тези методи внимателно, за да противодействате на пристрастията, това може да стане сериозно в модела на AI.

Архитектура

Архитектурата на модела и типът алгоритъм за машинно обучение, който избирате, също могат да въведат пристрастия. Някои алгоритми привличат пристрастия повече от други, заедно с това как са проектирани.

Избор на функция

Функциите, които сте избрали за обучение на AI алгоритъм, са една от причините за отклонение. Ако не изберете функции, като вземете предвид тяхното въздействие върху честността на изхода, може да възникне известно пристрастие, което да даде предимство на някои категории.

История и култура

Ако даден алгоритъм се захранва и обучава на данни, взети от историята или определени култури, той може да наследи пристрастия като предразсъдъци, вярвания, норми и т.н. Тези пристрастия могат да повлияят на резултатите от ИИ, дори ако са несправедливи и неуместни в настоящето.

Дрейф на данни

Данните, които използвате за обучение на своите AI алгоритми днес, може да станат неуместни, безполезни или остарели в бъдеще. Това може да се дължи на променящите се технологии или общество. Въпреки това, тези набори от данни все още могат да въведат пристрастия и да попречат на производителността.

Вериги за обратна връзка

Някои AI системи не само могат да комуникират с потребителите, но и да се адаптират към тяхното поведение. По този начин алгоритъмът може да увеличи съществуващото отклонение. Така че, когато личните пристрастия на потребителите влязат в AI системата, тя може да генерира предубедена обратна връзка.

Как да открием алгоритмично отклонение?

Определете какво е „честно“

За да откриете несправедливи резултати или пристрастия в алгоритмите, трябва да дефинирате какво точно означава „справедливо“ за AI системата. За целта можете да вземете предвид фактори като пол, възраст, раса, сексуалност, регион, култура и др.

Определете показателите за изчисляване на справедливост, като равни възможности, прогнозен паритет, въздействия и т.н. След като дефинирате „справедливост“, става по-лесно за вас да откриете какво не е справедливо и да разрешите ситуацията.

Данни за обучение по одит

Анализирайте обстойно данните си за обучение, за да потърсите дисбаланси и несъответствия в представянето на различни категории. Трябва да прегледате разпределението на характеристиките и да проверите дали то представлява демография от реалния свят или не.

За визуализиране на данни можете да създадете хистограми, топлинни карти, диаграми на разсейване и т.н., за да подчертаете несъответствията и моделите, които не могат да бъдат разкрити само с помощта на статистически анализ.

Освен вътрешни одити, можете да включите външни експерти и одитори, за да оцените системните пристрастия.

Измерете производителността на модела

За да откриете отклонения, опитайте да измерите ефективността на вашия AI модел за различни демографски данни и категории. Би било полезно, ако разделите обучението на различни групи въз основа на раса, пол и т.н. Можете също да използвате своите показатели за справедливост, за да изчислите разликите в резултатите.

Използвайте подходящи алгоритми

Изберете алгоритми, които насърчават справедливи резултати и могат да се справят с пристрастия при обучение на AI модел. Алгоритмите за справедливост имат за цел да предотвратят пристрастия, като същевременно гарантират равни прогнози в различните категории.

Софтуер за откриване на пристрастия

Можете да използвате специализирани инструменти и библиотеки, които са наясно с справедливостта, за да откриете пристрастия. Тези инструменти предлагат показатели за справедливост, визуализации, статистически тестове и други за откриване на пристрастия. Някои популярни са AI Fairness 360 и IBM Fairness 360.

Потърсете отзиви от потребителите

Попитайте потребителите и клиентите за техните отзиви относно AI системата. Насърчете ги да дадат своите честни отзиви, ако са почувствали някакъв вид несправедливо отношение или пристрастие в системата на ИИ. Тези данни ще ви помогнат да разберете проблеми, които може да не са маркирани в автоматизирани инструменти и други процедури за откриване.

Как да смекчим пристрастията в алгоритмите

Диверсифицирайте вашата компания

Създаването на разнообразие във вашата компания и екип за разработка позволява по-бързо откриване и премахване на пристрастията. Причината е, че пристрастията могат да бъдат забелязани бързо от потребителите, които са засегнати от тях.

Така че диверсифицирайте вашата компания не само по демографски данни, но и по отношение на умения и опит. Включете хора от различен пол, идентичност, раса, цвят на кожата, икономически произход и т.н., както и хора с различен образователен опит и произход.

По този начин ще можете да събирате широкообхватни гледни точки, опит, културни ценности, харесвания и нехаресвания и т.н. Това ще ви помогне да подобрите справедливостта на вашите AI алгоритми, намалявайки пристрастията.

Насърчаване на прозрачността

Бъдете прозрачни с вашия екип относно целта, алгоритмите, източниците на данни и решенията относно AI система. Това ще позволи на потребителите да разберат как работи AI системата и защо генерира определени резултати. Тази прозрачност ще насърчи доверието.

Алгоритми за справедливост

Използвайте алгоритми, съобразени с справедливостта, когато разработвате модела, за да гарантирате генерирането на справедливи резултати за различни категории. Това става очевидно, ако създадете AI системи за силно регулирани индустрии като финанси, здравеопазване и др.

Оценете производителността на модела

Тествайте вашите модели, за да изследвате ефективността на AI в различни групи и подгрупи. Това ще ви помогне да разберете проблемите, които не се виждат в обобщените показатели. Можете също така да симулирате различни сценарии, за да проверите тяхното представяне в тези сценарии, включително сложни.

Следвайте етичните указания

Формулирайте някои етични насоки за разработване на AI системи, зачитайки справедливостта, поверителността, безопасността и човешките права. Трябва да наложите тези насоки във вашата организация, така че справедливостта да се повиши в цялата организация и да се отрази в изходните данни на AI системата.

Задайте контроли и отговорности

Определете ясни отговорности за всеки в екипа, който работи по проектирането, разработването, поддръжката и внедряването на AI системата. Трябва също така да зададете правилни контроли със строги протоколи и рамки за справяне с пристрастия, грешки и други проблеми.

Освен горното, трябва да извършвате редовни одити, за да намалите пристрастията и да се стремите към непрекъснати подобрения. Освен това бъдете в крак с последните промени в технологиите, демографските данни и други фактори.

Примери от реалния свят на алгоритмични отклонения

#1. Алгоритъмът на Amazon

Amazon е лидер в индустрията за електронна търговия. Въпреки това, неговата инструмент за набиране на персонал които използваха AI за оценка на кандидатите за работа според техните квалификации, показаха пристрастност по отношение на пола. Тази AI система е обучена с помощта на автобиографии на предишни кандидати за техническите роли.

За съжаление, данните имаха по-голям брой кандидати от мъжки пол, което AI научи. Така че неволно облагодетелства кандидатите мъже на технически позиции пред жените, които са недостатъчно представени. Amazon трябваше да прекрати инструмента през 2017 г., въпреки че полага усилия за намаляване на отклонението.

#2. Расистки алгоритми за здравеопазване в САЩ

Алгоритъмът, който базираните в САЩ болници използваха за прогнозиране на пациенти, нуждаещи се от допълнителни грижи, беше тежък предубеден към белите пациенти. Системата оценяваше медицинските нужди на пациентите въз основа на тяхната история на разходите за здравеопазване, като съпоставяше разходите с медицинските нужди.

Алгоритъмът на системата не отчита как белите и черните пациенти плащат за своите здравни нужди. Въпреки неконтролираното заболяване чернокожите пациенти плащат предимно за спешни случаи. По този начин те бяха категоризирани като по-здрави пациенти и не отговаряха на изискванията за допълнителни грижи в сравнение с белите пациенти.

#3. Дискриминиращият алгоритъм на Google

Открита е онлайн рекламната система на Google дискриминиращ. Той показа високоплатени позиции като главни изпълнителни директори на мъжете значително повече от жените. Дори ако 27% от главните изпълнителни директори в САЩ са жени, представителството им е много по-малко в Google, около 11%.

Алгоритъмът би могъл да покаже резултата чрез изучаване на потребителското поведение, като хората, които гледат и кликват върху реклами за високоплатени роли, са мъже; AI алгоритъмът ще показва тези реклами на мъже повече, отколкото на жени.

Заключение

Алгоритмичните отклонения в системите за машинно обучение и изкуствен интелект могат да доведат до несправедливи резултати. Тези резултати могат да повлияят на хора в различни области, от здравеопазване, киберсигурност и електронна търговия до избори, заетост и др. Това може да доведе до дискриминация въз основа на пол, раса, демография, сексуална ориентация и други аспекти.

Следователно е важно да се намалят пристрастията в алгоритмите за AI и ML, за да се насърчи честността на резултатите. Информацията по-горе ще ви помогне да откриете пристрастия и да ги намалите, за да можете да създадете справедливи AI системи за потребителите.

Можете също да прочетете за управлението на AI.